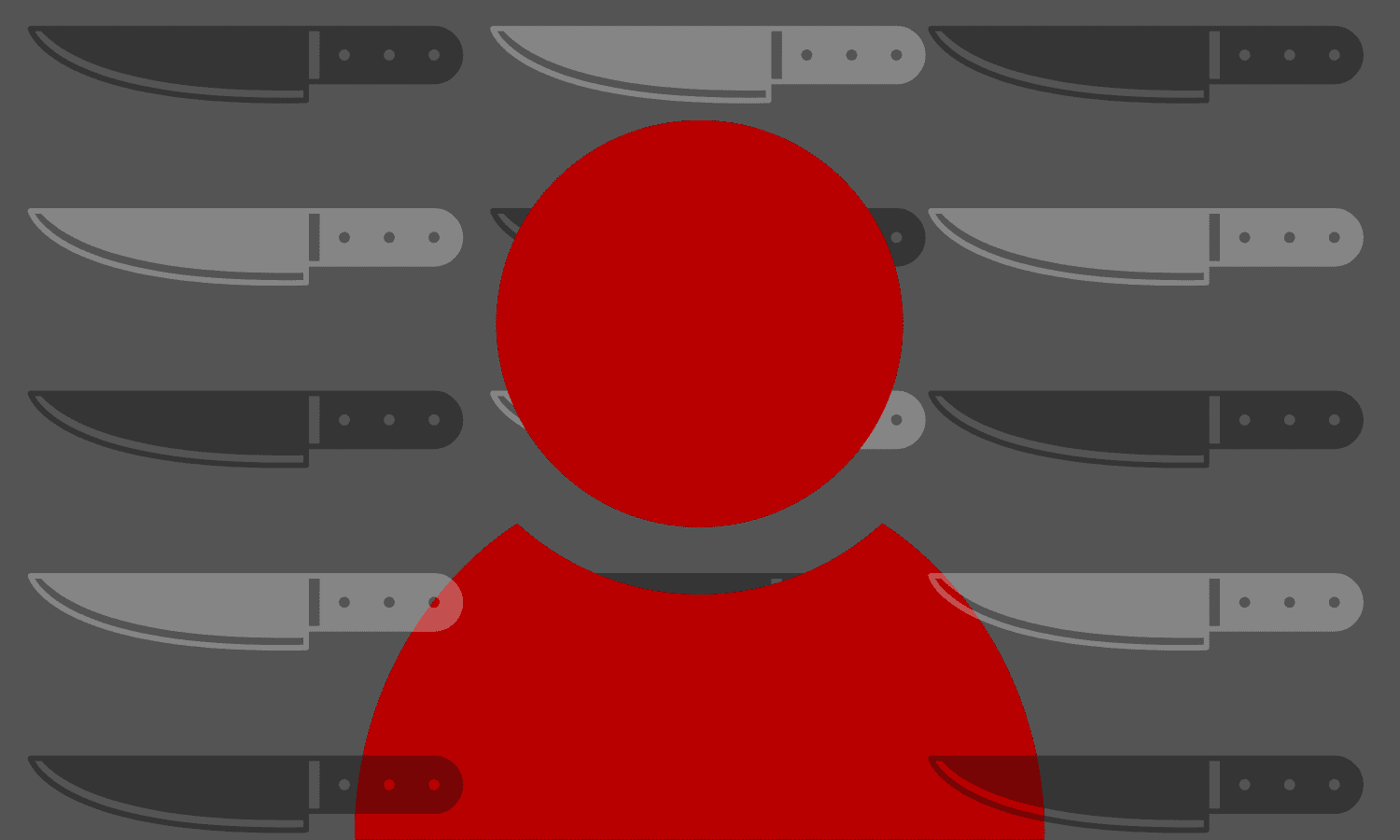

¿Cuáles son las consecuencias psicológicas de moderar contenido?

El precio de moderar la red

Los moderadores de contenido desempeñan un papel crucial para evitar la legitimización de la violencia y su influencia, a corto y largo plazo, en los usuarios de redes sociales. Su función, a menudo invisible, nos protege del sufrimiento e incluso de la exaltación y celebración del mismo. Pero ¿cómo se les protege a ellos?

Artículo

Si quieres apoyar el periodismo de calidad y comprometido puedes hacerte socio de Ethic y recibir en tu casa los 4 números en papel que editamos al año a partir de una cuota mínima de 30 euros, (IVA y gastos de envío a ESPAÑA incluidos).

COLABORA2025

Artículo

Como si fuera una tortura psicológica. Así podrían describir algunas personas el trabajo de los moderadores de contenido. Sin ellos, Facebook, Instagram, X (antes Twitter), Tik Tok, Youtube o WhatsApp serían espacios digitales donde las imágenes de asesinatos, abusos, maltratos, terrorismo, bestialismo, suicidio o pornografía infantil estarían normalizadas, al alcance de cualquier usuario y de forma continuada. Aunque gran parte de los contenidos se revisan de manera automática por sistemas de inteligencia artificial (IA), a menudo las decisiones de esta IA dependen de unos ojos humanos, esto es, de un trabajador.

Los algoritmos cada vez son más agudos y precisos, pero (aún) son incapaces de detectar la desinformación, la sátira, la relevancia cultural de una imagen o el contexto político de la empresa. De ahí la necesidad de que la moderación en la red dependa asimismo de las personas.

El uso de las redes sociales por parte de los usuarios no siempre va acompañado de una actitud ética, cívica o acorde a la legalidad. Es aquí donde aparece una nueva oportunidad de negocio y por ende, un nuevo perfil profesional. Proteger y limitar el contenido que puede ser lesivo o provocar un grave impacto social, como la incitación al odio, la desensibilización ante la violencia o la revictimización, constituye hoy una responsabilidad por parte de las compañías de redes sociales. Sin embargo, la responsabilidad que esas empresas tienen sobre la salud mental de sus trabajadores se encuentra cada vez más cuestionada (OIT, 2019). De un tiempo a esta parte, se han hecho públicas diferentes quejas y demandas de los moderadores de contenido en diferentes partes del mundo, con respecto a las empresas que les contratan y sus condiciones laborales. Un ejemplo de esto lo encontramos en el documental The Cleaners (2018) o en sentencias pioneras, como la que recientemente ha reconocido como accidente laboral las secuelas de un moderador de contenidos de CCC Barcelona Digital Services SL, empresa subcontratada por Meta.

Algunas sentencias pioneras reconocen como accidente laboral las secuelas de moderar contenidos online

Es evidente que la naturaleza, las condiciones y la localización del trabajo se encuentran cada vez más influidas por la digitalización. El impacto de esta cuarta revolución industrial se manifiesta a menudo en cómo trabajamos, quién trabajará y bajo qué coste para nuestra seguridad y salud. La pantalla no es aséptica y el sufrimiento también aparece cuando interaccionamos en el mundo digital. Desde una perspectiva clínica, la literatura científica ya advierte de que la exposición continuada a material sensible, incluso cuando se trata de forma indirecta, puede tener importantes consecuencias en la salud mental de las personas (Bor et al., 2018; Smahel et al. 2020). La investigación actual también admite que no todas las personas son igualmente vulnerables a los efectos de los medios y que determinadas condiciones individuales y contextuales median en lo que respecta a esta relación (Funk et al., 2004; Bushman, 2016; Dodemaide et al., 2022).

Difícilmente podemos señalar un factor de riesgo único como el responsable de los efectos que tiene en la salud la exposición continuada a contenido violento. En el caso de quienes trabajan identificando y denunciando el horror, es la acumulación de riesgos lo que lesiona su salud mental. A la vigilancia digital se le añaden otros riesgos, algunos propios de la actividad (como el trato con el usuario, el uso intensivo de las TIC o la monitorización constante y permanente del trabajo) y otros directamente relacionados con el uso de las plataformas (condiciones laborales precarias, inseguridad contractual, elevado ritmo de trabajo y presión de tiempos, jornadas largas, inadecuación de los espacios de trabajo, confidencialidad extrema, tecnoestrés, agotamiento físico y emocional, aislamiento y falta de apoyo psicológico para procesar lo observado). Los diferentes factores se interrelacionan entre ellos, favoreciendo los riesgos preexistentes y la aparición de otros nuevos.

La subcontratación en la moderación de contenidos implica trabajadores aislados y sin acceso a medidas de prevención y protección

Con relación a ello, cabe destacar cómo ha ido cambiando la moderación de los contenidos en los últimos años. Al principio, esta tarea recaía principalmente en las mismas empresas. En la actualidad, en cambio, la subcontratación de la moderación de contenidos se ha convertido en lo más habitual. Esto resulta especialmente problemático cuando el trabajador está en casa, sin apoyo de otros colegas o superiores, sin accesibilidad para el apoyo psicológico en la sede de la empresa o ha sido contratado sin valorar su idoneidad psicológica para tal función. Los riesgos psicosociales aumentan cuando no hay un espacio de socialización que valide y sostenga las dificultades de estos trabajadores, no se garantiza la implementación y desarrollo de medidas proactivas para proteger su salud mental o se prescinden de protocolos específicos de selección de personal.

El procedimiento práctico de estas medidas no solo pasa por intervenir en casos de emergencia o cuando el daño psíquico derivado de la moderación de contenidos inadecuados ya se ha producido. La prevención, en el ámbito organizacional, resulta fundamental para abordar los desafíos psicológicos que enfrentan estos trabajadores. Esta cuestión se traduce en anticipar los riesgos y asegurar que las consecuencias en salud mental asociadas a la moderación de contenidos puedan ser abordadas en un entorno laboral favorable y con servicios de atención psicológica efectivos.

COMENTARIOS