La ética del dato: hacia el ‘homo algorithmus’

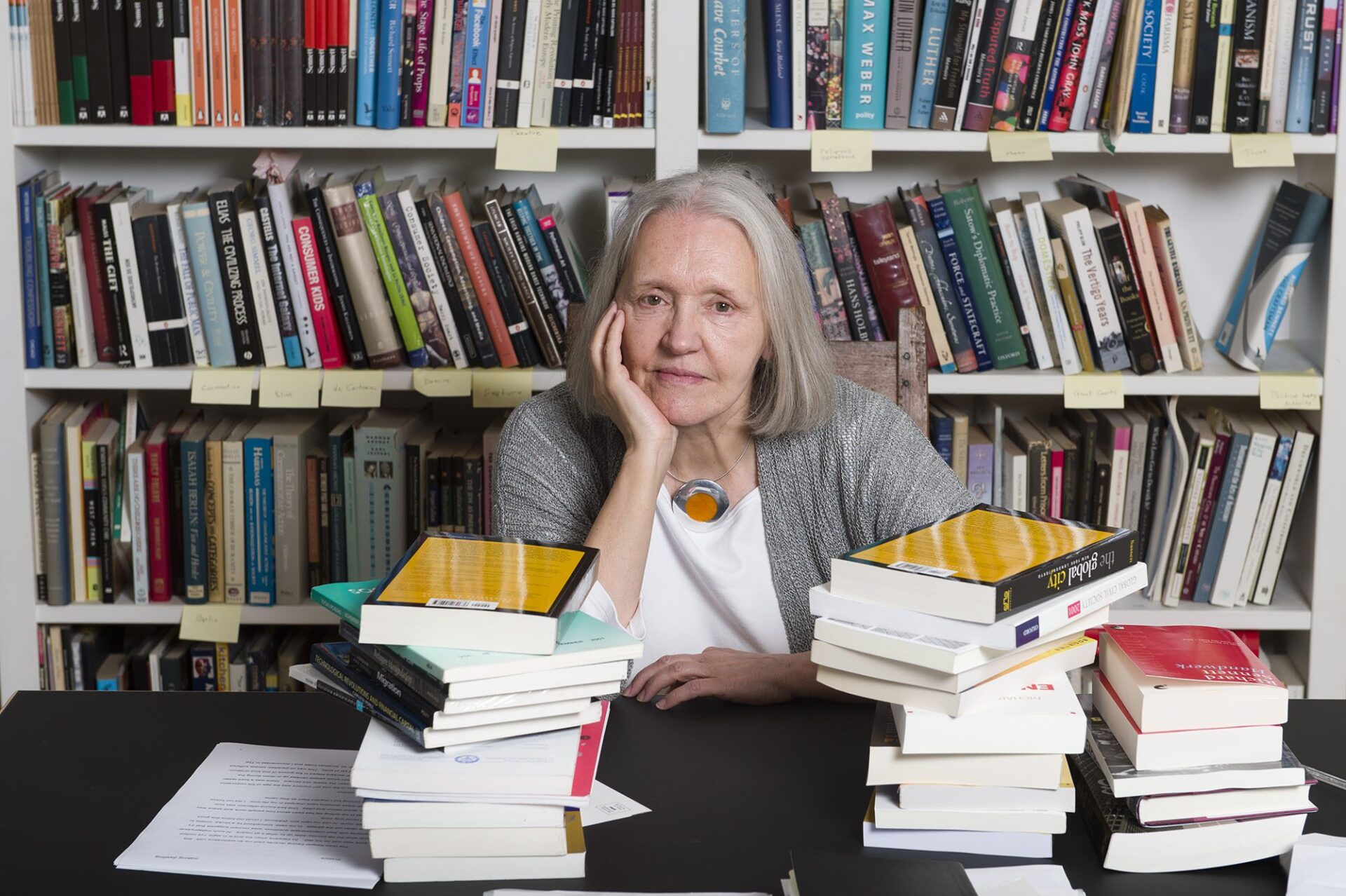

Juan Manuel López Zafra y Ricardo A. Queralt plantean en ‘Alquimia: Cómo los datos se están transformando en oro’ (Deusto) los dilemas que emanan de un sistema económico y social en el que las decisiones y responsabilidades se diluyen entre los océanos de datos y los algoritmos que los dirigen.

Artículo

Si quieres apoyar el periodismo de calidad y comprometido puedes hacerte socio de Ethic y recibir en tu casa los 4 números en papel que editamos al año a partir de una cuota mínima de 30 euros, (IVA y gastos de envío a ESPAÑA incluidos).

COLABORA2021

Artículo

Sábado 21 de mayo de 2016. Tras negarse a coger el autobús para viajar desde Taftan, en la frontera pakistaní con Irán, el mulá Akhtar Mohamed Mansur se sube a un Toyota Corolla de alquiler con conductor camino de Quetta, a más de 600 kilómetros al este. Mansur es, desde hace un año, el líder de los talibanes tras hacerse oficial la muerte del mulá Omar. Tras 450 kilómetros de viaje, una explosión destruye el vehículo, matando a sus dos ocupantes. El secretario de Estado estadounidense, John Kerry, señaló desde Myanmar que Mansur suponía «una inminente y continua amenaza al personal estadounidense en Afganistán, a los civiles afganos, a las fuerzas de seguridad afganas y a los miembros de la coalición internacional». El presidente de Estados Unidos y premio Nobel de la Paz, Barack Obama, añadió: «Como jefe de los talibanes, [Mansur] tenía específicamente como blanco a funcionarios y militares de Estados Unidos dentro de Afganistán, quienes estaban allí como parte de la misión que he asignado para mantener una plataforma para combatir el terrorismo y proporcionar asistencia y entrenamiento a las fuerzas militares afganas».

El vehículo de Mansur fue destruido por un MQ-9 Reaper recién entrado en servicio, un aparato de unos 20 metros de largo, alrededor de cinco toneladas de peso y una autonomía de 14 horas que le permite volar a una altitud de entre 12.000 y 15.000 metros, a una velocidad de hasta 300 km por hora, cargado con cuatro misiles Hellfire y varias bombas más. Sustituía al Predator MQ-1. Este avión no tripulado llevaba en servicio desde 1999, y suponía una evolución del anterior dron de reconocimiento RQ-1.

Este tipo de drones se denominan, técnicamente, VANT o vehículos aéreos no tripulados. Están dotados del equipamiento tecnológico adecuado para llevar a cabo sus misiones de forma autónoma, desde el despegue hasta el aterrizaje, pasando por el guiado, la identificación del objetivo, el marcado del blanco y el disparo. Todas las capacidades están disponibles, y, sin embargo, el disparo jamás es efectuado de forma independiente por la aeronave, sino por un piloto, que es quien, situado a centenares de kilómetros, decide apretar el gatillo. En la actualidad, el ejército de Estados Unidos dispondría de más pilotos de drones que de aviones de transporte C17 e incluso que de F-16, algo que por sí solo revela la importancia que las nuevas formas de guerra están adoptando. Este tipo de guerra plantea dilemas éticos más allá de los tradicionales. Bajo el concepto de guerra justa existe toda una doctrina que desciende hasta Cicerón, crece con san Agustín, y se perfecciona en la Edad Media, fundamentalmente dentro de la tradición católica. Esta aproximación nace de una paradoja: considerar la guerra como intrínsecamente perversa y, al mismo tiempo, considerarla necesaria en determinadas ocasiones, fundamentalmente para preservar la libertad y evitar males mayores a la sociedad. De acuerdo con esa aproximación, el uso de drones estaría justificado, pero debería ser siempre un individuo quien tome la decisión de disparo, consciente del valor de una vida y de la posibilidad de errar en la selección del blanco.

«Dejamos un rastro digital que, casi siempre, modifica las relaciones de afecto, las económicas, incluso las relaciones de poder»

Esta consideración está cambiando, entre otras cosas por los episodios de estrés postraumático que muestran los pilotos de los drones. A pesar de la capacidad de actuar del propio VANT, quien al final toma la decisión de disparo es, como hemos señalado, el piloto. Desde 2017, el Pentágono está inmerso en un proyecto de mejora de los sistemas autónomos para que la acción de disparo sea, también, decisión del propio dron. Fundamentalmente, se trata de entrenarlo mediante redes neuronales de aprendizaje profundo, empleando miles de horas de vídeo con millones de imágenes para que el sistema aprenda las características de los elementos ante los que debe reaccionar. El Equipo Multifuncional de Guerra Algorítmica, o Proyecto MAVEN, es el encargado de la misión de procesar esa documentación gráfica, casi siempre de baja calidad. Con ese fin ha lanzado la segunda convocatoria del reto UG, dotado con más de 60.000 dólares en premios. El objetivo es la investigación tanto en algoritmos de aprendizaje profundo (los mejor preparados para la tarea) como en cualesquiera otros que permitan la identificación y clasificación de objetos móviles, sin restricción del tipo, así como la detección de objetos en condiciones adversas de visibilidad. Para ello se proporciona un conjunto de más de 162.000 imágenes,123 anotadas y documentadas, procedentes de casi trescientos vídeos con más de 1,2 millones de fotogramas, con los que los equipos pueden entrenar y validar los distintos algoritmos. Las imágenes proceden tanto de VANT como de planeadores tripulados y de tomas estáticas, controladas, en tierra, en muy diversas condiciones tanto de luminosidad como atmosféricas. Una vez más, los datos son esenciales para que el sistema de decisiones automáticas pueda funcionar.

Los datos están modificando la forma en que nos relacionamos con nuestro entorno. Ciudadanos, empresas y Gobiernos dejamos un rastro digital que, casi siempre, modifica las relaciones de afecto, las económicas, incluso las relaciones de poder. Una vida más sencilla se abre ante nuestros ojos; sin embargo, existen dudas, normales, acerca de cómo será ese mañana. Uno de los principales problemas al que nos enfrentamos tiene que ver con el proceso de toma de decisiones en un entorno en el que la inteligencia digital está pensada para, precisamente, actuar de forma autónoma. Si bien los militares llevan tiempo enfrentándose a la cuestión, tal como acabamos de poner de manifiesto, existen otras áreas, mucho más cercanas a nuestra vida diaria en las que la ética inherente a todo proceso de decisión sale a la luz de forma mucho más evidente para todos nosotros.

Nos referimos, por ejemplo, al dilema al que se enfrentan, ya, los coches autónomos, cuando deben decidir entre impactar contra un peatón o evitarlo, poniendo entonces en peligro a sus ocupantes. En octubre de 2018 se publicó en Nature «The Moral Machine Experiment», resultado de una encuesta a más de dos millones de personas en todo el mundo para tratar de establecer la validez de un código moral universal para la resolución de cuestiones como la planteada. Se analizaron más de 40 millones de decisiones en más de 233 países, y las únicas coincidencias de todas las culturas fueron las de preferir salvar a personas antes que a animales, y a grupos antes que a individuos. Sólo Audi, el fabricante alemán, señaló que el estudio presentaba elementos importantes de discusión, otras compañías envueltas en la producción de este tipo de vehículos, como Waymo, Uber o Tesla, omitieron hacer comentarios al respecto. La postura no es baladí, pues tiene importantes e inmediatas connotaciones de tipo comercial; quién comprará un coche sabiendo que, llegado el caso, puede ser sacrificado. En ese sentido, Mercedes ya decidió en 2016 que sus vehículos autónomos, empujados al límite de la decisión, salvarían la vida de sus pasajeros antes que la de los peatones.

«Quién comprará un coche sabiendo que, llegado el caso, puede ser ‘sacrificado’»

La gestión empresarial también se ve impactada por este tipo de consideraciones. En el mes de noviembre de 2018 tuvo lugar la quinta reunión del CDO Club Spain, en la que se trató de forma monográfica la ética del dato, poniendo de manifiesto la importancia que la cuestión tiene para los responsables del dato en España. Elena Gil, directora general de Luca, señaló cuatro áreas en las que los retos éticos son en especial importantes: la privacidad, la discriminación, la responsabilidad y la transformación del entorno laboral. Algunas empresas han formado equipos para investigar la ética de las decisiones algorítmicas; tal es el caso de Microsoft, cuyo grupo Fairness, Accountability, Transparency, and Ethics in Artificial Intelligence (FATE, equidad, responsabilidad, transparencia y ética en inteligencia artificial) intenta dar respuesta a procesos automatizados que afectan directamente a la vida de las personas.

En febrero de 2014, el ministerio de Interior británico desarrolló una investigación para comprobar si el reportaje de Panorama era cierto o no. De acuerdo con ese programa de la BBC, se estaba produciendo un fraude masivo y sistemático en las pruebas del Test of English for International Communication (TOEIC), el examen oficial para conocer las aptitudes lingüísticas de los candidatos a un visado para establecerse en el Reino Unido, y de cuya superación depende. Para llevar a cabo el control de las pruebas, el ministerio, de acuerdo con la política de «entorno hostil» llevada a cabo por su entonces cabeza Theresa May, contrató a la empresa English Test Services, que mediante un algoritmo de reconocimiento de voz señaló casi 34.000 pruebas fraudulentas y marcó otras 23.000 como cuestionables. A finales de 2016, el ministerio había revocado casi 36.000 visados de otros tantos estudiantes. Sin embargo, cuando se contrastó la eficacia del algoritmo, se comprobó que el número de falsos positivos ascendía a un 20 por ciento, lo que supuso que alrededor de 7.000 estudiantes fueron expulsados sin haber, necesariamente, cometido fraude en la prueba de idioma.

En Canadá, una investigación de la Facultad de Derecho de la Universidad de Toronto denunció que la sustitución de la toma de decisiones de individuos por algoritmos en la política inmigratoria canadiense estaba afectando negativamente a los «derechos humanos fundamentales» de los afectados. De acuerdo con una de las responsables de la investigación, lo que esta revela es «la necesidad urgente de crear un marco para la transparencia y la responsabilidad para abordar el sesgo y el error en relación con las formas de toma de decisiones automatizadas». Desde 2014, el departamento de inmigración canadiense viene introduciendo paulatinamente procesos de apoyo a las decisiones basados en datos e inteligencia artificial. Algunas cuestiones son fáciles de resolver, como la correcta cumplimentación de la documentación, pero otras son claramente más complejas, como la evaluación de matrimonios (que podrían ser fraudulentos) o la identificación de perfiles «de riesgo». Los autores plantean que la decisión basada en rasgos físicos, en patrones de viaje o incluso en las creencias religiosas puede llevar a situaciones discriminatorias, al incorporar a individuos a grupos comunes y excluirles sin darles la oportunidad de justificarse. El debate entre seguridad y derechos está en la base del problema, así como el problema de los errores que pueden cometerse y su jerarquización: alguien debe decidir qué es más grave, un falso positivo (que alguien sea calificado como «no apto», siendo falso) o el falso negativo (que alguien sea calificado como «apto», cuando en realidad no lo sea, con el muy pequeño riesgo, pero de consecuencias catastróficas, que plantea para la sociedad en el caso de terroristas que se aprovechan de la situación). Mientras tanto, el Gobierno de Ottawa ha ampliado la aplicación de estos algoritmos, con la idea de aumentar la capacidad y la velocidad de análisis de sus funcionarios.

El problema de la ética en la toma de decisiones basada en algoritmos plantea cuatro marcos de actuación que se solapan en mayor o menor grado. Qué se puede hacer con un algoritmo (marco exterior, pues sus capacidades son enormes y crecientes), cuál es el límite legal (definido actualmente por el Reglamento General de Protección de Datos, en vigor desde mayo de 2018, pero sólo aplicable en la Unión Europea, lo que plantea retos adicionales, como más adelante veremos), qué quiere hacer la empresa u organización (voluntad tanto autoimpuesta como limitada siempre por los dos marcos anteriores) y cuál es el límite ético. Este suele ser el más restrictivo de los cuatro, pero es evidente que puede ser muy volátil en virtud de las circunstancias sociales y culturales, como ya hemos señalado. Es por ello por lo que el problema ético debe analizarse de forma global en el seno de la administración y en el de la empresa, en este caso no sólo en su cúpula directiva, aunque, sin duda, principalmente en ella.

Este es un fragmento de ‘Alquimia: Cómo los datos se están transformando en oro‘ (Deusto), por Juan Manuel López Zafra y Ricardo A. Queralt.

COMENTARIOS